Chemia w XX wieku

Chemia w XX wieku

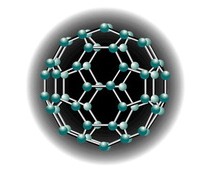

W większości plebiscytów na największe osiągnięcia człowieka w XX stuleciu rzadko kiedy dostrzega się dzieła chemików. Synteza nawozów sztucznych wydaje się mało wzniosła w porównaniu z teorią kwantów, a kataliza przegrywa w społecznej recepcji z wynikami biologii molekularnej. Paradoksalnie jednak powszechny brak zrozumienia osiągnięć chemików w XX w. uznać powinno się za dowód wielkiej skuteczności tej dyscypliny. To właśnie ona zmieniła w dopiero co zakończonym stuleciu każdy niemal aspekt naszego funkcjonowania. Po prostu, życie bez chemii stało się niemożliwe, a jeśli ktokolwiek to neguje, powinien za radą H.W. Kroto, brytyjskiego laureata Nagrody Nobla, odkrywcy fulerenów — nowej postaci węgla, raz w tygodniu wchodzić na pół dnia na drzewo rezygnując całkowicie z produktów chemii. Powodzenia.

Tworzenie fundamentów

Jeśli przeniesiemy się o nieco ponad sto lat wstecz, dostrzeżemy dziwną sytuację w nauce. Fizycy są sfrustrowani — wydaje im się, że wiedzą wszystko, niczego więcej odkryć się już nie da. Zupełnie inaczej przedstawia się sytuacja chemików, którzy zaczynają doceniać skuteczność matematycznych metod opisu świata molekularnego. J.H. van't Hoff, S.A. Arrhenius, W.F.W. Ostwald tworzą podstawy chemii fizycznej — udaje im się opisać językiem formalizmu matematycznego tak ważne dla chemików zjawiska, jak przebieg reakcji chemicznych, równowaga reagujących ze sobą substancji, zachowanie substancji w roztworach.

Matematyka definitywnie wyrywa chemię z obszaru nauk ezoterycznych, z dziedzictwa alchemii, gdzie nieprzenikniona wiedza o transformacji materii dostępna była jedynie wtajemniczonym. Wspomniani uczeni udowodnili, że chemia jest nauką nie mniej ścisłą niż fizyka. Trudno więc się dziwić, że pierwsze Nagrody Nobla w dziedzinie chemii przypadły właśnie twórcom chemii fizycznej.

Wspomniana frustracja fizyków skończyła się dokładnie w 1900, kiedy za sprawą M.K.E. Plancka narodziła się teoria kwantów. Fizyka z dziedziny martwej przekształciła się w niezwykle płodne pole badań, a zmiany związane z powstaniem mechaniki kwantowej nie mogły pozostać bez wpływu na stan rzeczy w chemii. Kluczowym bowiem dla chemików zagadnieniem jest problem wiązania chemicznego. Jak powstaje? Co decyduje o jego trwałości? Jakie muszą być spełnione warunki, by dwa atomy lub cząsteczki zechciały utworzyć nowy byt?

Teoria kwantów w chemii

Poprawny opis wiązania chemicznego stał się możliwy dopiero po wyjaśnieniu przez fizyków budowy atomu i opracowaniu teorii powłok (orbitali) elektronowych, w czym kluczową rolę odegrał Duńczyk N.H. Bohr. Z kolei pionierem zastosowania metod mechaniki kwantowej w chemii był L.C. Pauling, jeden z najwybitniejszych i najciekawszych uczonych tego stulecia. W 1939 opublikował dzieło The Nature of the Chemical Bond, które szybko zyskało miano klasyki i przez dziesięciolecia wchodziło w skład kanonu podręczników dla adeptów sztuki chemicznej.

Prawdziwy jednak rozwój chemii kwantowej nastąpił po II wojnie światowej. Równania mechaniki kwantowej stają się niezwykle złożone dla tworów tak skomplikowanych jak cząsteczki. Do ich skutecznego rozwiązania nie wystarcza już kartka i ołówek, potrzebne są komputery. Ich upowszechnienie po wojnie otworzyło zupełnie nowe perspektywy przed chemikami. Rozpoczął się fascynujący „pojedynek” między teoretykami, którzy przekonywali, że są w stanie na podstawie obliczeń matematycznych przewidywać właściwości układów chemicznych i eksperymentatorami, twierdzącymi, że świat cząsteczek jest zbyt skomplikowany, by poznawać go inaczej, niż przez doświadczenie.

Ważką rolę w tym pojedynku odegrał wielki polski uczony, W. Kołos, jeden z twórców chemii kwantowej. Podczas pracy w laboratorium C. Roothaana w Chicago w latach 60. przedstawił on uzyskane wspólnie z L. Wolniewiczem wyniki obliczeń dotyczących cząsteczki wodoru. Rezultaty te odbiegały od wyników eksperymentalnych uzyskanych przez „papieża” spektroskopii, G. Herzberga. Możliwe były trzy odpowiedzi: pomylił się Kołos, pomylił się Herzberg, metody mechaniki kwantowej nie nadają się do rozwiązywania problemów chemii. Okazało się, że to G. Herzberg źle zinterpretował eksperyment, co przyznał w 1971 podczas wykładu noblowskiego.

Te klasyczne już dla historii chemii zmagania miały istotne konsekwencje. Chemicy z innych dyscyplin przestali traktować chemię kwantową i teoretyczną jako egzotyczną odmianę fizyki, nieprzydatną w laboratorium. Aparat teoretyczny stał się niezbędny dla właściwej interpretacji wyników doświadczeń, jak również dla skuteczniejszego ich przygotowania. Współpraca R. Hoffmanna i R.B. Woodwarda, dwóch wielkich chemików z tak wydawało się odległych dziedzin, jak chemia kwantowa i synteza organiczna doprowadziła do opracowania w latach 60. niezbędnych w laboratorium organicznym reguł Woodwarda-Hoffmanna.

Dziś, gdy moc komputerów coraz bardziej tanieje i staje się coraz powszechniejsza, a jednocześnie dostępne jest wyspecjalizowane oprogramowanie, trudno sobie wyobrazić chemika, który przed przystąpieniem do pracy — syntezy nowego leku lub próby rozszyfrowania struktury przestrzennej nieznanej cząsteczki, nie korzystałby (często nawet sobie nie zdając z tego sprawy) z osiągnięć chemii kwantowej.

Analiza — oko chemika

Rozwój aparatu teoretycznego umożliwił powstanie nowoczesnych metod analizy chemicznej, dzięki którym bezkształtne osady i roztwory w probówkach nabrały konkretnych kształtów i właściwości. Wykorzystanie promieni rentgenowskich do „prześwietlania” kryształów cząsteczek chemicznych doprowadziło do powstania w okresie międzywojennym metod analizy rentgenowskiej, najdokładniejszego sposobu określania kształtów cząsteczek. To właśnie te metody umożliwiły stworzenie portretów najpierw cząsteczek tak prostych jak sól kuchenna, by w końcu umożliwić opisywanie złożonych molekuł o znaczeniu biologicznych — białek i kwasów nukleinowych.

Sukces J.D. Watsona i F.H.C. Cricka w rozszyfrowaniu struktury DNA nie byłby możliwy bez wyników analizy rentgenowskiej uzyskanych przez Dorothy Hodgkin. Jednym z ciekawszych wyników wykorzystania analizy rentgenostrukturalnej w 2000 było poznanie struktury prionu — białka, którego patologiczna forma wywołuje chorobę „szalonych krów”.

Współcześni chemicy mają do dyspozycji cały arsenał metod analitycznych: różne odmiany spektroskopii umożliwiające wgląd w naturę wiązań chemicznych, spektrometrię masową, metody spektroskopii rezonansu magnetycznego (NMR) będące podstawowym orężem chemików syntetyzujących nowe cząsteczki. Materia na poziomie dostępnym chemikom przestała praktycznie być tajemnicą. Istnieją już w zasadzie wszystkie narzędzia potrzebne, by poznać strukturę cząsteczek oraz oglądać „na żywo” przebiegające między nimi reakcje.

Podglądanie reakcji chemicznych

Jak już wspomnieliśmy wcześniej, reakcje są w chemii kluczowym problemem. Nic więc dziwnego, że od dawna uczeni pragnęli dokładniej przyjrzeć się ich przebiegowi. W 1949 R. Norrish i G. Porter opracowali metodę fotolizy błyskowej. By nie wchodzić w szczegóły, metodę tę można opisać przez analogię do fotografii. Jeśli chcemy uzyskać wyraźne, ostre zdjęcie poruszającego się obiektu, musimy ustawić aparat na jak najkrótszy czas otwarcia migawki. Jadący szybko samochód sfotografowany z migawką 1/30 s pojawi się na zdjęciu jako rozmyta plama. Migawka 1/2000 zapewni poprawny obraz.

Podobnie jest z reakcjami chemicznymi. Przebiegają one z różną szybkością, jeśli jednak uda się skonstruować „aparat fotograficzny” o szybkiej migawce, to będzie można zrobić zdjęcie trwającej reakcji. Metoda fotolizy błyskowej pozwoliła wyjaśnić wiele ciekawych problemów, jednak „migawka” o czasie ekspozycji rzędu milionowej części sekundy była zbyt powolna. Kolejne metody, których rozwój nabrał wielkiego tempa po wynalazieniu akcji laserowej i wprowadzeniu przez fizyków kolejnych, coraz doskonalszych urządzeń umożliwiły powstanie femtochemii.

W metodzie opracowanej przez Egipcjanina A. Zewaila przebieg reakcji można badać z dokładnością do femtosekundy (a więc 10–15 sekundy). Za swe rezultaty A. Zewail otrzymał chemicznego Nobla w 1999. Większe dokładności nie są już potrzebne. Rozpoczęte jeszcze pod koniec XIX w. przez J.H. van't Hoffa i S.A. Arrheniusa teoretyczne rozważania na temat przebiegu reakcji chemicznych u schyłku XX stulecia zyskały narzędzie do definitywnego rozstrzygania problemów na drodze eksperymentu. Wielka zagadka materii przestała istnieć.

Ubiegłe stulecie chemicy zakończyli ze świadomością, że wiedzą już niemal wszystko o materii na poziomie cząsteczkowym i atomowym. Wiedzą, jak wyglądają molekuły i mają skuteczne narzędzia, by poznawać nowe. Wiedzą, jak cząsteczki ze sobą reagują i dysponują narzędziami, by wyjaśniać ewentualne zagadki. Dalszy rozwój metod analitycznych pójdzie w kierunku zwiększania czułości i dokładności metod. Chemicy mogą zająć się spełnianiem marzeń dawnych alchemików — tworzeniem materii o najbardziej fascynujących właściwościach.

Nowa materia

Koniec XIX w. to z jednej strony wielkie prace fizykochemików, wprowadzających do chemii precyzyjny język matematyki, z drugiej zaś niezwykle ważne, prekursorskie prace wielkich syntetyków. W 1890 niemiecki chemik E.H. Fischer zsyntetyzował cząsteczkę cukru d–glukozy. Wagę tego osiągnięcia lepiej można zrozumieć, jeśli weźmie się pod uwagę, że E.H. Fischer nie dysponował żadną z opisanych powyżej metod analitycznych. Sukces tej skomplikowanej (nawet w dzisiejszych czasach) syntezy był efektem połączenia wiedzy, geniuszu i eksperymentalnej odwagi. W efekcie powstała więcej, niż tylko cząsteczka chemiczna — została wskazana droga rozwoju chemii w XX w.

Chemicy podejmowali kolejne próby tworzenia coraz bardziej skomplikowanych cząsteczek, w 1917 R. Robinson otrzymuje nową metodą tropinon. Opracowana wcześniej przez Niemca R. Willstättera synteza wymagała 19 etapów. R. Robinson pokazał w niezwykle elegancki sposób, że cząsteczki można projektować w podobny sposób, jak inżynierowie projektują mosty i budynki, dochodząc tym samym do optymalnej drogi postępowania.

Jednocześnie zaczął rozwijać się prawdziwy przemysł chemiczny — jednym z jego pionierów był A. von Baeyer, który zasłynął z badań nad barwnikami syntetycznymi. Fala rewolucyjnych odkryć w pierwszych dekadach stulecia zaczęła wzbierać. P. Ehrlich wynalazł salwarsan, skuteczny lek przeciwko syfilisowi (przypomnijmy, że choroba ta była sto lat temu dotkliwsza i bardziej rozpowszechniona, niż AIDS dzisiaj). Narodziła się chemioterapia — podstawa nowoczesnej medycyny. Kolejnym etapem wkraczania chemii do leczenia było wynalezienie przez G. Domagka sulfonamidów, leków przeciwbakteryjnych, które w okresie międzywojennym, zanim pojawiły się antybiotyki uratowały niezliczone rzesze ludzi przed śmiercią na skutek banalnych, z dzisiejszego punktu widzenia, infekcji.

Chemioterapię uznać należałoby jednak za wątpliwą przysługę dla ludzkości, gdyby nie prace niemieckiego chemika F. Habera. Opracował on metodę syntezy amoniaku z azotu atmosferycznego. Metoda ta udoskonalona przez C. Boscha stała się podstawą rozwoju przemysłu nawozów sztucznych, który wywołał rewolucję w rolnictwie. Rosła, za sprawą zmniejszającej się umieralności (głównie w efekcie zastosowania nowych leków i nowoczesnych, chemicznych środków higieny) liczba ludzi na Ziemi. Ludzkość nie musiała jednak obawiać się spełnienia proroctwa Malthusa — znacznie szybciej bowiem zaczęła wzrastać produkcja rolna. W efekcie, na skutek nadprodukcji żywności kraje zamożne mogły sobie pozwolić pod koniec ubiegłego stulecia na powrót do „naturalnych” metod rolnych, a nawet do zmniejszania powierzchni terenów uprawnych. Głód jest dziś wyłącznie problemem politycznym.

Epoka plastiku

Wielkie rzesze ludzi trzeba nie tylko wykarmić, ale i odziać, zapewnić mieszkania i wiele innych, niezbędnych do życia rzeczy. Znowu, jak w przypadku niedoboru żywności, w sukurs przyszła chemia. Kolejna rewolucja to zapoczątkowana w okresie międzywojennym epoka tworzyw sztucznych. Kamieniem milowym było wynalezienie przez L.H. Baekelanda bakelitu, twardego, sztywnego tworzywa, które wiele osób pamięta z obudowy telefonu i radioodbiornika. Jeszcze przed wojną opracowano metody syntezy tak dziś popularnych tworzyw jak polietylen, nylon i teflon. Prawdziwa jednak eksplozja przemysłu tworzyw sztucznych wybuchła po II wojnie. Z jednej strony fundamentalne, prowadzone jeszcze przed wojną prace teoretyczne H. Staudingera doprowadziły do zrozumienia, czym tak naprawdę są polimery. Z drugiej strony wspólne, powojenne prace Niemca K. Zieglera i Włocha G. Natty wniosły nowy impuls do metod projektowania plastików o określonych właściwościach. Wspomniani uczeni (uhonorowani Nagrodą Nobla w 1953) wyjaśnili rolę katalizatorów oraz wpływ warunków reakcji na strukturę produktów polimeryzacji.

Dziś chemicy mogą wręcz dowolnie wytwarzać tworzywa sztuczne o zadanych z góry właściwościach. Powstają materiały o niespotykanej wytrzymałości, obdarzone „inteligencją” (np. polimery zdolne do uwalniania substancji leczniczej tylko w określonych warunkach fizjologicznych). Wiek XX zakończył się przyznaniem Nagrody Nobla z chemii trzem uczonym (H. Shirakawa, A.G. MacDiarmid, A.J. Heeger), którzy opracowali polimery zdolne do przewodzenia prądu elektrycznego. Zapoczątkowane przez nich badania stały się podstawą poszukiwań materiałów, które mają szansę zrewolucjonizować przemysł komputerowy i elektroniczny.

Inżynieria molekularna

Antycypowana w syntezie R. Robinsona inżynieria molekularna rozkwitła z pełną mocą po II wojnie światowej. Szczytowe osiągnięcia kunsztu syntetycznego na zawsze łączyć się będą z takimi nazwiskami, jak R. Woodward lub E.J. Corey. R. Woodward opracował jeszcze w czasie wojny metodę otrzymywania chininy, by potem pokazywać swoje mistrzostwo w tak trudnych projektach, jak synteza strychniny, chlorofilu i witaminy B12. Udowodnił on, zanim zmarł przedwcześnie, że dla chemika nie ma zbyt trudnych wyzwań — każda synteza jest tylko kwestią pomysłu i wiedzy. Jednocześnie, jak już wspomnieliśmy, miał on wielkie zrozumienie dla roli teorii podczas projektowania optymalnej drogi syntezy — stąd jego owocna współpraca z wielkim chemikiem teoretykiem, R. Hoffmannem.

Osiągnięcia „następców” R. Woodwarda fascynują, choć już nie wywołują zdumienia — synteza tak złożonych cząsteczek jak taksol, amfoterycyna, rezerpina i setki innych stały się niemal rutynowymi wyzwaniami dobrych laboratoriów. Syntetyków wspierają teorie i komputery o coraz większej mocy obliczeniowej. Ich sukcesy nie byłyby jednak możliwe bez kolejnej rewolucji w chemii XX stulecia — nowoczesnej katalizy. Ze szkoły wiemy, że katalizator to substancja, która ułatwia przebieg reakcji, choć sama po jej zakończeniu pozostaje w stanie nienaruszonym. Nowoczesne katalizatory coraz bardziej zbliżają się do swych naturalnych odpowiedników — enzymów. Nie tylko ułatwiają przebieg reakcji, ale umożliwiają precyzyjne sterowanie jej przebiegiem, tak aby w efekcie powstały tylko oczekiwane przez chemika produkty. Jednym z wyzwań podczas syntezy substancji organicznych jest ich tzw. czynność optyczna — cząsteczki te, choć mają ten sam wzór chemiczny, różnią się jednak przestrzennym ułożeniem swoich fragmentów, co objawia się różnym sposobem oddziaływania ze światłem spolaryzowanym. Często zdarza się, że forma lewoskrętna substancji może być cennym lekiem, podczas gdy forma prawoskrętna wykazywać silne właściwości toksyczne. Zastosowanie odpowiednich katalizatorów umożliwia otrzymanie od razu pożądanych form substancji, skracając znacznie drogę do nowych leków.

Chemia supramolekularna

W drugiej połowie XX w. chemicy nauczyli się nie tylko budować nowe substancje. Odkryli również możliwość tworzenia struktur ponadmolekularnych; stwierdzili, że w odpowiednich warunkach niezależne cząsteczki mogą się zespalać tworząc struktury o niezwykłych właściwościach. Odkrycia tego dokonali w latach sześćdziesiątych J.-M. Lehn, Ch. Pedersen i D.J Cram. Tworzone przez nich substancje zdolne były do wychwytywania jonów określonej wielkości. Zapoczątkowana przez tych chemików (otrzymali Nagrodę Nobla w 1987) chemia supramolekularna jest dziś kwitnącą dyscypliną. Dostarcza ona wiedzy o samoorganizacji cząsteczek chemicznych, co ma ogromne znaczenie dla rozwoju nanotechnologii i jest podstawą w pracach nad tzw. komputerem chemicznym — komputerem, w którym operacje wykonywane są na poziomie pojedynczych cząsteczek.

Skuteczność nowoczesnej chemii widać najlepiej na przykładzie przemysłu farmaceutycznego. Poszukiwanie nowych leków to ciągle największe z wyzwań stojących przed nauką. I ciągle dostarczanie nowych substancji leczniczych jest dziełem laboratoriów chemicznych. Misja chemika polega na tym, by opracować cząsteczkę, która w możliwie najsilniejszy sposób wiązać się będzie z cząsteczką odpowiedniego receptora w organizmie, a silne połączenie wywoła kaskadę reakcji fizjologicznych, w wyniku których choroba ustąpi. Korzystając z nowoczesnego oprogramowania stworzonego przez chemików teoretyków, na monitorze komputera syntetyk próbuje zaprojektować optymalny kształt cząsteczki leku.

Ta metoda może jednak tylko przybliżyć do rozwiązania problemu. W ostatnim etapie i tak trzeba wyprodukować tysiące cząsteczek niewiele różniących się od siebie — doświadczenie pokazuje bowiem, że wśród tych tysięcy może znaleźć się taka, której aktywność wielokrotnie przewyższy aktywność „konkurencji”. Jeszcze w latach osiemdziesiątych oznaczało to konieczność długotrwałych, żmudnych syntez przez rzesze chemików. Zdolny syntetyk potrafi uzyskać 50–100 nowych substancji w ciągu roku. W latach dziewięćdziesiątych nastąpił jednak wielki przełom związany z rozwojem chemii kombinatoryjnej. Dzięki automatyzacji procesu syntezy, zaprogramowane roboty są w stanie tworzyć kilkadziesiąt tysięcy różnych cząsteczek w ciągu roku, przyspieszając tym samym proces poszukiwania nowych, obiecujących substancji.

Epilog

Pełny opis rozwoju chemii w XX stuleciu wymagałby wielkiej księgi. Przedstawione powyżej rewolucyjne idee, które zmieniły nie do poznania życie ludzi w ciągu zaledwie stu lat to tylko niewielki fragment dorobku chemików. Zabrakło miejsca na niemniej istotne osiągnięcia, jak środki ochrony roślin, detergenty, elektrochemię i wynikające z niej prace nad nowymi źródłami energii, przetwórstwo surowców naturalnych, chemię nieorganiczną (nowe materiały dla przemysłu elektronicznego), chemię produktów spożywczych, termodynamikę procesów nierównowagowych, olbrzymi obszar badań z pogranicza chemii i biologii. Sam katalog problemów wyczerpałby objętość niniejszego omówienia.

Mimo niewątpliwego dorobku chemia nie cieszy się na początku XXI w. dobrą opinią. Po okresie społecznej euforii (zwłaszcza w latach sześćdziesiątych) publiczna aprobata dla pracy chemików gwałtownie zmalała. Tysiące dzieci cierpiących na wady rozwojowe na skutek stosowania przez matki w ciąży thalidomidu, tysiące zabitych podczas awarii elektrowni w Bhopalu, dziura ozonowa i skażenie środowiska są argumentami przeciwko chemii. Jako antidotum wskazuje się powrót do natury, odejście od produktów przemysłu chemicznego. To jednak postulat zupełnie nierealny, możliwy do proponowania wyłącznie przez pięknoduchów z cierpiących na przejedzenie krajów bogatego Zachodu.

Na wspomniane porażki chemii jedynym ratunkiem jest tylko dalszy rozwój chemii. Nowoczesne metody syntezy są coraz bardziej „zielone”, do produkcji leków i tworzyw sztucznych używa się coraz mniej szkodliwych substancji. Doskonalsze metody projektowania cząsteczek chronią przed kosztownymi, zbędnymi poszukiwaniami. Z kolei lepiej zaprojektowane cząsteczki — leku lub tworzywa sztucznego — są skuteczniejsze, potrzeba więc ich mniej, by uzyskać właściwy efekt. Tym samym zmniejsza się obciążenie dla środowiska naturalnego.

Chemię XX w. określa się mianem nauki centralnej, będącej łącznikiem między fizyką a biologią. Granice między tymi dyscyplinami będą się coraz bardziej zacierać. Niemożliwa jest nowoczesna biologia bez metod chemicznych; chemicy zaś ciągle szukają inspiracji w świecie organizmów żywych. Wygląda na to, że w ciągu najbliższych kilkudziesięciu lat nastąpi rozkwit syntezy chemicznej, jako głównego sposobu zaopatrywania mieszkańców Ziemi w coraz doskonalsze materiały i substancje. O ile wyzwaniem dla chemików na początku XX stulecia było produkowanie wielkich ilości stosunkowo prostych produktów: nawozów sztucznych, polietylenu, barwników, o tyle dziś jest tworzenie nowych form materii, spełniających najbardziej nawet wydumane potrzeby człowieka.

Edwin Bendyk